几年前 W.J.T 米切尔来华参加世界艺术史大会时有一场题名《方法、疯癫与蒙太奇》 的讲座,讲座内容暂且不论,光是标题就充分吸睛,以致未来几年里被人反复提起,也重新唤起了中国研究者对瓦尔堡(Aby Warburg)的兴趣。假如特德·姜所说在事实上没错——ChatGPT 就是网上所有文本的模糊图像,而不是某种更强大的东西,也并没有从这张模糊图像中习得某些特殊能力——那么最为合适的回应,正是尝试理解马赛克的价值:一张涂满连线的马赛克或许并不能提供精确的知识,正如面对瓦尔堡的《记忆女神图像集》(Bilderatlas Mnemosyne)并不是要看清某一张图片的样子,而是在持续的集合、排列、重组中,感受欣喜、恐惧、晕眩与疯狂。

断章取义

断章取义,其意自见

ChatGPT 是网上所有文本的模糊图像

与此同时,我们有理由提出这样一个问题:重新表述万维网有何用途?如果我们永远无法访问互联网,不得不在空间有限的私人服务器上存储副本,那么像ChatGPT这样的大语言模型可能是一个很好的解决方案,假设它可以防止伪造。但我们并没有失去对互联网的访问。那么,当你还有原始图片的时候,一张模糊的JPEG到底有多大用处呢?

特德·姜将 ChatGPT 比作「互联网上所有文本的模糊图像」,并追问「重新表述互联网有何用途」。如果存在一张 JPEG 的原件,人们为什么还要去看一张模糊的图像?

特德·姜从隐喻出发,我们可以用另一个隐喻回应:胶片的解析度远远不如数字相机,那么《断背山》是比 4K 120HZ 的《双子杀手》更差的电影吗?

分辨率并不意味着一切,清晰度只是人们需要的指标之一。人类既喜欢原件与清晰,却也喜欢滤镜与模糊,尤其是当雾里看花被发展成一种特殊的美学形态。

在最低限度的想象中,人类也能将 ChatGPT 发展为博格斯特所说的审美工具。在更符合实际的想象中,我们会发现:人类的一面是 4K 与 BeReal,另一面则是暧昧与谎言。

ChatGPT 背后的经济账

训练大语言模型并不便宜,但也没那么烧钱,训练大语言模型需要大量的前期投入,但这些投入会逐年获得回报。更进一步,Chinchilla论文表明,在未来,相比资金,高质量数据会成为训练LLM的新兴稀缺资源之一,因为扩展模型参数数量带来的回报是递减的。

讨论 LLM 的成本结构及其未来的潜在发展:一、LLM 驱动的搜索在经济上可行,成本估计为目前搜索引擎收入的 15%;二、LLM 驱动的企业有很高的利润率;三、对于大公司来说,训练 LLM 模型的成本并不高;四、预计 LLM 成本在未来会大幅下降;五、目前数据是 LLM 性能的新瓶颈。译文原因,未讨论中文地区成本以及训练成本,本地化仍有其他问题(标注成本、硬件封锁等)有待讨论。

生成式人工智能与工作的未来

或许将出现一个时尚市场,强调无需人工智能的「素食」内容?现在还为时过早,无法预测。

生成式人工智能准备彻底改变我们创造和处理信息的方式,可能会改变工作的未来。正在开发由人工智能驱动的工具,以帮助人们提高生产力,但也存在着对信任、知识产权和剽窃的担忧。生产力提高的背面既有可能是日常语言的窄化甚至丧失。

数字世界的清洁工

这个检测器的原理很简单:通过提供带有标签的暴力、仇恨言论和性虐待的例子,让AI学会检测这些形式的毒性。这个检测器将会内置于ChatGPT,用于检查其是否存在与训练数据中毒性的相似之处,并在传送给用户之前过滤掉。

OpenAI 和过去的 FB 一样利用非洲廉价劳动力进行数据标注。在非洲公司 SAMA,人工每小时工资在 2 美金左右,公司则收到了约 12.5 美金。员工需要处理大量性虐待、仇恨言论和暴力描述相关的文本,正是这些数据标记与清理的工作,使得 ChatGPT 越发智能、礼貌且政治正确(作为对比,新 Bing 完美呈现了未清洗数据的 GPT 将是什么样子)。作为一种政治上的想象,我们不妨将数据标记与清理人员,看作数字世界的清洁工:终日与污秽为伴,躲藏在下水道与遥远东方,维持着清洁的现代生活的表面。

拆解追溯 GPT-3.5

在这篇博文中,我们仔细检查了 GPT-3.5 系列的能力范围,并追溯了它们所有突现能力的来源。初代 GPT-3 模型通过预训练获得生成能力、世界知识和 in-context learning。然后通过 instruction tuning 的模型分支获得了遵循指令和能泛化到没有见过的任务的能力。经过代码训练的分支模型则获得了代码理解的能力,作为代码训练的副产品,模型同时潜在地获得了复杂推理的能力。结合这两个分支,code-davinci-002 似乎是具有所有强大能力的最强 GPT-3.5 模型。接下来通过有监督的 instruction tuning 和 RLHF 通过牺牲模型能力换取与人类对齐,即对齐税。RLHF 使模型能够生成更翔实和公正的答案,同时拒绝其知识范围之外的问题。

追溯 GPT3.5 的各项能力——响应人类指令、泛化没见过的任务、代码生成和代码理解、思维链与推理——来源,「复杂推理的能力来自于代码训练」是非常强力吸睛的假设。眼下有标准 API 了,预计很快能看到基于基准测试的更详尽的分析。

学书不成

学书不成,学剑不成

《罗杰疑案》

欺骗没有发生,一切都公平公正,问题出现在叙事间隙,在字里行间,在语言深处。《罗杰疑案》所说的道理是如此简单直白:语言不可能穷尽世界的所有,语言也不是为了穷尽(一个或许根本不存在的)一切而存在。这是属于推理小说的哥德尔不可能定理:一切叙述都注定不可靠,一切叙述者都必然成为不可靠的叙述者,越是希望获得稳定性,形式系统就越是需要封闭,以至于变成卡尔狭小的房间,可越是如此,系统之外就越是暴风骤雨。也正是通过对自己所处的整个黄金时代的反讽,《罗杰疑案》的死亡证明了推理小说可以在形式游戏中发展出超越元素,在房间之中窥探/想象房间之外,只是它的读者未必能够承受此种变形。

《谁杀死了罗杰·艾克罗伊德?》

有别于暴露、伪装与转移,巴雅认为「故意疏漏」彻底破坏了文本的可信度,揭开了文本与「现实」之间的疤痕,并使作者与读者不得不面临侦探小说内在的问题:谋杀的多义和答案的一元;单次的阅读与重复的阅读;以及最根本的现实的不存在——「作品中世界的缺失并非是因为信息缺乏,而是因为结构缺失。如果是信息缺失,可通过找寻信息,一如历史学科那样,有朝一日得以弥补。须知此世界所惧怕的并非是已失却的完全性,因为它从未完整过。」叙述性诡计是让文本彻底向外部开放的写作,因为它并不伪装文本闭合的表象,而是揭穿了中间世界的存在,并且召唤读者进入其中。至于谵妄、理论、真相、主体、侦探与凶手的精神分析游戏,本质上只是巴雅响应召唤的一次行动,在文本留下的巨大间隙前,答案为何已经不再重要。

秉烛夜游

秉烛夜游,昼短夜长

失眠

一个体量小、画风精美的解谜游戏。从女主人公的视角出发,描绘了在失眠的夜晚,大脑内经常会上映的各种小剧场。

沉浸在网络世界信息流瀑布里的厌烦,追悔曾经做过的糗事,懊恼某一句有漏洞的话,回忆小时候的童真和温情,担忧未来的生活……这些失眠夜里人们心中经常会产生的共同思绪,被画成一幕幕精美的场景呈现在眼前。灯光的昏黄和夜色的深蓝是主色调,被一分为二的是在床上辗转反侧的自己和飘逸奔驰的思绪。失眠是割裂的,身体在床上而思维在空中,是第二天的头痛脑热,也是灵感迸发的源泉。

如果你失眠,不妨也可以玩玩。遇到解谜的地方过不去,四处乱点就行。

玩物丧志

玩物丧志,岂不美哉

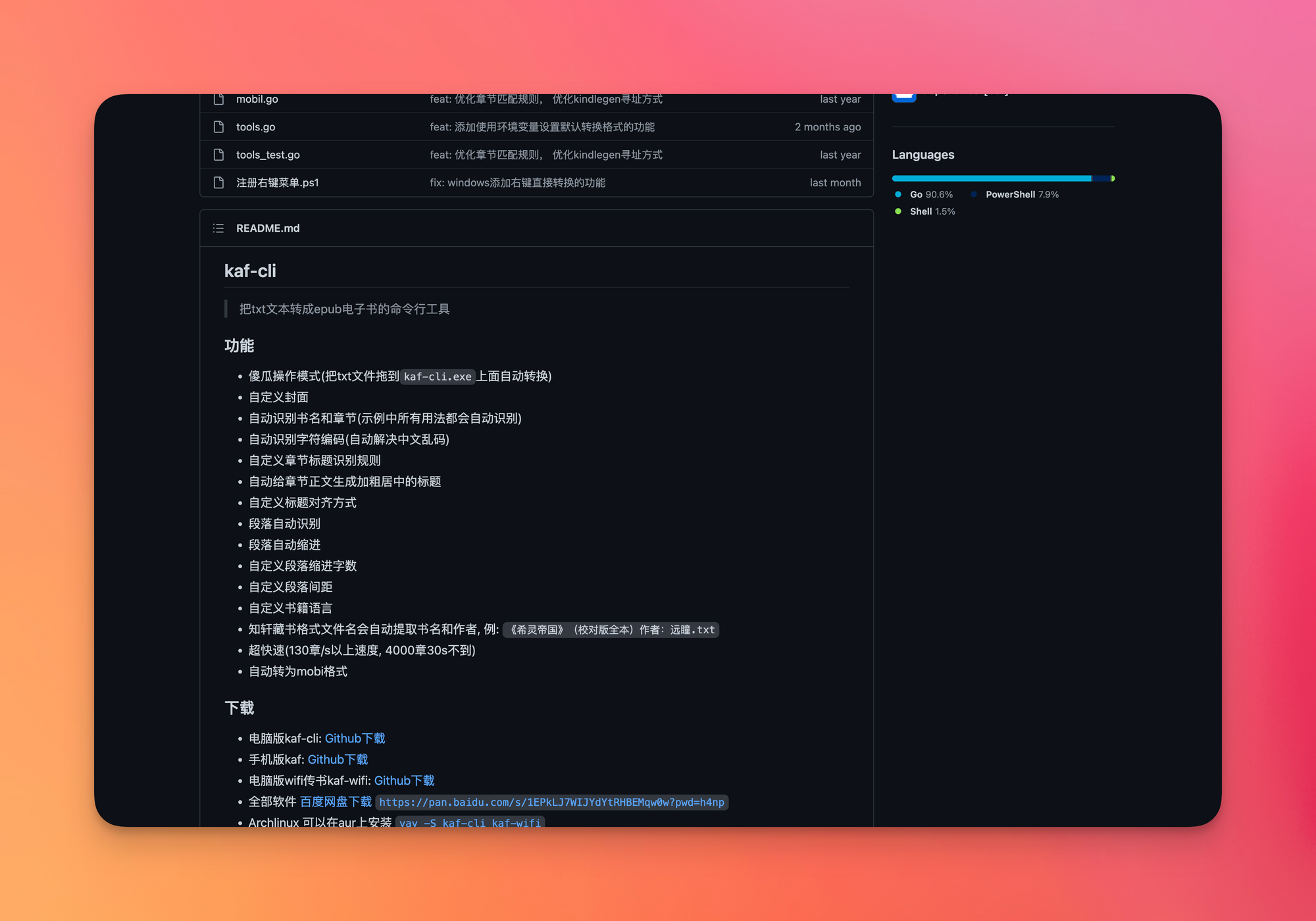

重度使用一段时间 Obsidian 之后终于还是无法忍受糟糕的编辑和管理体验,用回了Scrivener和Ulysses。然而Obsidian也有自己的长处:插件多。为求翻小说方便,去年专门买了支持微信读书的电纸书,之后凡是流式文档(EPUB、MOBI)都丢到微信读书看,并且用此插件同步记录到本地存档。想要达到最好的效果需要根据自己需求修改一下同步模板,难度不大,稍微尝试一下就好。

家属最近又开始看网文,著名的网文下载脚本多日没有维护,加之站点死的死跑的跑,哪怕是找一些晋江热门也是难于登天。想起此前收藏的 TXT 转 EPUB 工具,索性下了个 TXT 版本来转换试试。作者看得出是网文老油条,配置项非常多(对齐、间距、封面、语言、格式),脚本也对各种格式的标题做了兼容,基本能自动匹配上(实在不行就写个正则去手动匹配)。Windows 使用更加简单,拖放一下就好,Mac 或 Linux 需要手动跑一下命令行并且过一下安全设置,嫌命令行麻烦可以自动跑完丢进 Calibre 再修整一下。